Tìm hiểu Web Crawler là gì?

Dữ liệu được xem là một phần không thể thiếu của mỗi trang web bất kỳ khi thiết lập. Tuy nhiên, để giải quyết vấn đề người dùng thì ít mà kho dữ liệu thì nhiều khá khó khăn. Vậy tầm quan trọng của web crawler là gì đối với những trang web mới? Hãy theo dõi bài viết dưới đây bạn nhé!

Nên xem: Những điều cần biết về thuật toán algorithm – algorithm là gì?

Bạn đang xem: Tìm hiểu Web Crawler là gì?

Nội Dung

Web Crawler là gì? Mô hình của Crawler

Web Crawler là phần mềm được thiết kế với mục đích có thể duyệt website trên mạng World Wide Web một cách có hệ thống, giúp thu thập thông tin của những trang web đó về cho công cụ tìm kiếm.

Việc này sẽ mang lại khả năng lưu chỉ mục các trang web đó vào bộ cơ sở dữ liệu của Search Engine. Đồng thời, giúp các công cụ tìm kiếm đó tìm ra những đánh giá chính xác nhất về website được thu thập dữ liệu.

Mô hình crawler bao gồm như sau:

- Chọn URL để khởi đầu

- Sử dụng HTML protocol để có thể lấy trang web

- Trích xuất ra các link và lưu trữ lại trong queue

- Lặp đi lặp lại nhiều lần các bước 2,3

Các module quan trọng của 1 crawler chi tiết hơn như sau:

- URL Frontier chứa danh sách các đường dẫn URl chưa được lấy.

- Fetch module có thể lấy các trang web.

Chọn url để khởi đầu crawler

- DNS resolution module có khả năng xác định địa chỉ của server của trang web đã lấy.

- Parsing module trích xuất văn bản và link từ trang web đã lấy.

- Duplicate elimination module có tính năng loại bỏ các URL trùng lặp.

Những tên gọi của web crawler là gì?

Xem thêm : Infrastructure là gì? Nghề đỉnh cao của làng công nghệ số

Các tên gọi khác của crawler là robot, bot, spider, worm, ant, tuy nhiên gần đây tên gọi crawler vẫn là thông dụng nhất.

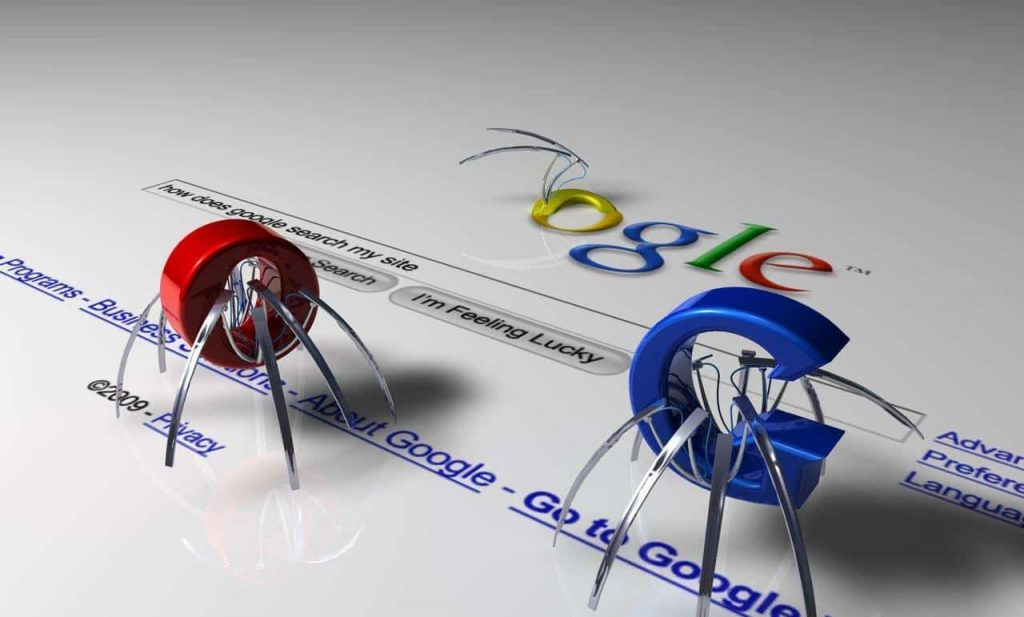

Spider nghĩa là gì?

Spider là cách gọi hình tượng hóa của Web Crawler, cái tên này được gọi dựa trên nguyên lý hoạt động và lưu thông tin của Web Crawler rất giống với những hoạt động của một con nhện. Bắt đầu từ một website bất kỳ, Spider sẽ len lỏi vào từng ngóc ngách ở trong trang đó và lần lượt truy cập vào từng liên kết có trên trang.

Sau đó nó sẽ đánh dấu các liên kết đã truy cập trước đó và nối các trang có link với trang gốc giống như việc tạo một sợi tơ liên kết 2 trang lại với nhau. Chỉ đơn giản từ một website ban đầu, Spider có thể nối thêm rất nhiều website lại để tạo nên một mạng lưới chằng chịt như một mạng nhện đích thực.

Tên gọi khác của web crawler là spider

Tên gọi Ant là gì?

Ant cũng là một cách gọi tương tự với spider, và cũng dựa trên cách lưu thông tin của trang web và các hoạt động của Web Crawler. Mỗi khi di chuyển, một con kiến thường tiết ra chất pheromone nhằm lưu lại vết đường mà nó đã đi qua. Việc đánh dấu liên kết này của Ant trên web cũng giống như việc tạo tơ nhện của Spider.

Cách gọi Crawler là gì?

Crawler là cách gọi theo chức năng của Web Crawler, tên gọi này có thể mô tả các hành động truy cập và thu thập dữ liệu của Web Crawler trên một website giống như một người hoặc một con bọ đang bò trườn trên trang đó.

Bot là gì?

Bot hay còn gọi với tên khác là Internet Bot, là một loại phần mềm ứng dụng chạy tự động trên Internet web robot có thể thực hiện một số công việc đơn giản và lặp đi lặp lại theo có hệ thống cho người sử dụng. Có thể nói, Web Crawler là một tập hợp con của Internet Bot.

Cơ chế hoạt động của Web Crawler là gì?

Web Crawler cso tính năng khám phá và tìm hiểu thông tin trên các trang web công khai hiện nay trên mạng WWW. Các công cụ thu thập thông tin hữu ích này sẽ lần lượt theo dõi các trang web và dò theo từng liên kết trên các trang đó.

Xem thêm : Xe SUV Là Gì?

Nó cũng giống như việc chúng ta duyệt từng nội dung có trên trang. Web Crawler thu thập dữ liệu trên các trang bằng việc lần lượt đi từ liên kết này tới liên kết khác và đưa các dữ liệu đó về cho máy chủ Search Engine.

Crawler có khả năng tìm kiếm và thu thập thông tin của website

Quá trình thu thập thông tin của phần mềm Web Crawler bắt đầu với một danh sách các địa chỉ website nào đó. Thông thường đó sẽ là danh sách các trang web được lưu từ những lần thu thập thông tin trước đó và danh sách do chủ sở hữu trang web gửi đến. Từ đó thu thập dữ liệu của tất cả các trang có liên quan, và đặc biệt ưu tiên các liên kết mới.

Phần mềm Web Crawler cũng xác định những trang web nào cần thu thập thông tin, tần suất trang cần tìm nạp từ mỗi trang web. Crawler hoạt động hoàn toàn tự động và ít chịu sự can thiệp bởi con người.

Sau khi thu thập đầy đủ tất cả thông tin, dữ liệu trang, các Crawler sẽ tổng hợp những dữ liệu đó với những dữ liệu ngoài trang như số lượng backlink trỏ đến website, lượng truy cập và gửi chúng về ngân hàng dữ liệu để được xét duyệt.

Cách để crawl là gì?

Để có thể crawl được các dữ liệu trên trang web, chúng ta cần quan tâm đến yếu tố đầu tiên đó là trang web bạn muốn crawl có bị chặn request hay không. Sau đó là vấn đề trang web bạn muốn crawl có cấu trúc có ổn định hay không?

Một trang web có cấu trúc internal ổn định sẽ dễ dàng để lấy data hơn là một trang web cấu trúc mỗi trang một định dạng khác nhau. Bởi lẽ khi chúng ta crawl sẽ chủ yếu dựa trên các element để lấy được data.

Trên bài viết là những thông tin cơ bản để bạn hiểu hơn về web crawler là gì và nguyên lý hoạt động của nó như thế nào. Chúc bạn sẽ là người quản trị mạng tài ba để trang web của mình luôn hoạt động hiệu quả.

Nguồn: https://25giay.vn

Danh mục: Hỏi Đáp